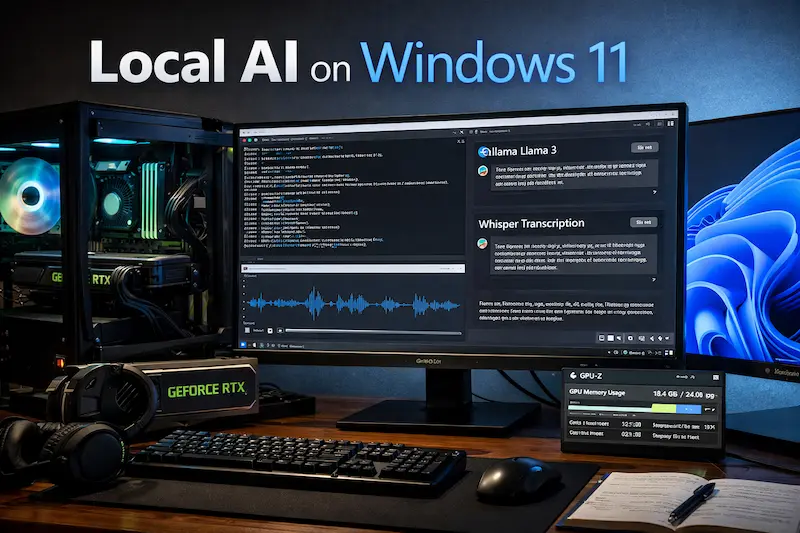

如果對訂閱制 AI 服務感到不划算,或是發現公司資料不適合丟上雲端,那麼自架 Local AI 本地部署是個可考慮的方向。本文引導你從電腦設定與 (1). 搭配顯示卡或 (2). 無顯示卡的兩種方式,運行 Open Source 的 TAIDE、Meta AI Llama 3、Mistral Small 3、Google Gemma、Falcon、Grok 模型,一路到進階的語音轉文字的應用,完整串聯專屬個人的 AI 工作環境。

本地化 AI 不僅能省掉訂閱置費用,更能讓模型深度貼合你的實際需求。透過量化(GGUF、AWQ)、GPU 配置與推論框架(如 llama.cpp、vLLM、Ollama),即使是家用電腦也能實現高品質 AI 推論。同時結合 RAG(檢索增強生成)、私有文件索引與自動化腳本,可以打造一套完全由自己掌控的 AI 系統,從內容生成、技術支援到內部知識管理,完全享受 Local AI 帶來的價值。

為什麼選擇 Local AI?基礎環境與 Docker 架設

在談模型、效能之前,環境穩不穩定才是成敗關鍵。如果是 Windows 11 的用戶,最實際、也最少踩雷的做法,就是透過 Docker 容器來架設 AI 環境。下面這篇教學文章中,將帶您從零開始,搭配適合運行的大型語言模型,讓個人電腦變身為私人 AI 伺服器。

優點:

1、電腦系統環境乾淨

2、軟體升級自行決定

3、避免套件衝突把 AI 系統搞掛

4、家用區域網路實現多用戶、不同裝置,共用同一台 AI 伺服器

參考文章:Windows 11 AI 助理: Docker + 本地模型自架區網家庭版 ChatGPT

打造 ChatGPT 的開源替代方案:AnythingLLM 與 Ollama 整合

假使需要一個友善的操作介面,要能聊天、要能丟文件、還要能反覆調整設定,AnythingLLM 搭配 Ollama 是目前的黃金組合。它不僅能像 ChatGPT 一樣與 AI 對話,還能上傳私有文檔建立知識庫(RAG)。透過這套組合,您可以完全掌控資料流向,無需擔心隱私外洩。

優點:

1、操作介面接近 ChatGPT,新手也能上手

2、支援私有文件知識庫(RAG)

3、模型完全在本機跑,資料不外流

參考文章:5 分鐘自架 ChatGPT !人人都能用AnythingLLM + Ollama秒殺官方版

進階玩家必學:載入 GGUF 模型與 Modelfile 客製化

Ollama 官方未提供的模型 ,都可透過 Modelfile 自行載入,並依實際需求細部調整模型參數。這種進階的作法完全避開 Ollama 模型下載速度緩慢、缺少特定微調版模型(例如 Llama 3)、繁體中文優化模型的缺點。

優點:

1、使用 Ollama 官方未提供的 GGUF 模型

2、自行決定要使用的量化模型

3、兼顧隱私、效能與彈性的本地個人知識庫

4、有限的 VRAM 條件下,跑更高參數的模型

參考文章:Modelfile 教學:5分鐘讓Ollama載入自定義GGUF並串接AnythingLLM

影音創作者利器:使用 Whisper 製作 YouTube 字幕

AI 不僅能處理文字,聲音辨識更是強項。OpenAI 的 Whisper 模型擁有驚人的辨識準確率。下面這篇文章,將一步步帶你完成如何在本地端執行 Whisper,生成 YouTube 字幕、長影片轉逐字稿,整個後製流程快非常多,大幅縮短影片後製的時間。

優點:

1、100% 免費使用

2、開源(open-source)的人工智慧模型

3、支援超過 99 種語言並轉錄成英文或原始語言的文字

4、Whisper 模型絕對不會追蹤或儲存用戶資料

參考文章:OpenAI Whisper 讓新手在 5 分鐘內生成影片字幕

辦公室生產力革命:構建自動化會議摘要系統

當大型語言模型(LLM)結合 Whisper ,最實用的應用之一就是生成會議摘要,打造一套【離線版】的會議記錄神器。不論是內部會議、訪談錄音、還是課程紀錄,都可以在完全離線的狀態下,生成逐字稿與條列式重點摘要。下面這兩篇文章分享如何利用 GPU 加速,將冗長的會議錄音轉為逐字稿,再自動生成條列式的重點摘要,完全在本機完成的實作記錄。

優點:

1、敏感資料不經過第三方伺服器

2、模型參數完全可調整

3、繁體中文處理精準度高

4、摘要邏輯性與條列式重點品質高

參考文章:本地部署 AI 會議紀錄工具實作教學:Windows 11 + GPU 加速

參考文章:AI 會議紀錄神器,上班族自架 Windows 11 + LLaMA 生成中英文摘要實作

硬體效能評估:如何計算您的 VRAM 需求?

運行 Local LLM 最常見的問題就是:我的顯示卡跑得動嗎?

不同的模型參數(如 8B, 70B)與量化等級(Q4, Q8)對 VRAM 的需求差異巨大。為了協助大家精準採購硬體,下面這款線上計算工具,能根據想跑的模型自動計算所需的 VRAM 與記憶體頻寬。

常見問題

什麼是 Local AI?

Local AI 指的是在使用者自己的本地端電腦或伺服器上運行人工智慧模型,而非透過雲端 API。這樣做可以確保資料隱私、降低延遲,並且無需支付訂閱費用。

運行 Llama 3 70B 模型需要多少 VRAM?

運行 Llama 3 70B 模型通常需要大量的 VRAM。如果是 Q4 量化版本,大約需要 40GB VRAM;如果是 Q8 版本,則可能需要超過 70GB,通常建議使用雙顯卡配置(如兩張 RTX 3090/4090)。

什麼是 GGUF 格式?

GGUF 是一種專為 CPU 和 GPU 推論最佳化的二進位檔案格式,特別適用於 llama.cpp。它允許模型在消費級硬體上更高效地運行,並支援多種量化等級以節省記憶體。

Ollama 是什麼?

Ollama 是一個開源工具,旨在簡化在本地端運行大型語言模型(如 Llama 3, Mistral)的過程。它將模型封裝並提供簡單的 API,讓開發者與一般用戶能輕鬆部署 AI。

Whisper 語音轉文字準確度高嗎?

OpenAI 的 Whisper 模型準確度極高,特別是在 Large-v3 版本中,對於多語言混合和專業術語的辨識能力,通常優於許多付費的雲端服務,且支援台語等多種語言。

如何在 Windows 上安裝 Docker?

在 Windows 上安裝 Docker Desktop 需要先啟用 WSL 2 (Windows Subsystem for Linux)。安裝後,您可以透過容器化技術快速部署 AnythingLLM 或 Open WebUI 等 AI 應用。

AnythingLLM 與 Open WebUI 有什麼不同?

AnythingLLM 專注於 RAG(檢索增強生成)與知識庫管理,適合企業與文檔處理;Open WebUI 則提供了類似 ChatGPT 的流暢使用者介面,功能豐富且外掛支援度高,適合一般對話使用。

本地端 AI 會議摘要系統安全嗎?

非常安全。因為所有的語音轉文字(Whisper)與摘要生成(LLM)都在您的本機電腦上運算,錄音檔與文字內容完全不會上傳至任何第三方雲端伺服器。

什麼是 RAG (檢索增強生成)?

RAG 是一種技術,允許 AI 模型在回答問題前,先檢索您提供的私有資料(如 PDF、Word 文檔)。這讓 AI 能夠回答它原本訓練資料中沒有的特定領域問題。

我需要多強的 CPU 才能跑 Local LLM?

雖然 GPU 的 VRAM 最重要,但 CPU 負責資料的前處理與傳輸。建議至少使用 Intel Core i5 或 AMD Ryzen 5 以上的處理器,並搭配足夠的系統記憶體(RAM),以確保模型載入順暢。

為何現在就該建置屬於自己的 Local AI 系統

雖然 Local AI 本地部署並不是一條最省事的路,但是一旦建立完成 AI 系統後,不僅能提升工作效率,更能確保資料絕對安全。只要基礎環境打穩,後續不論是模型升級、功能擴充,甚至整合進既有工作流程,都會越來越順。希望這篇整理,能讓你少踩雷、少走冤枉路,真正把 AI 變成日常可用的生產力工具。