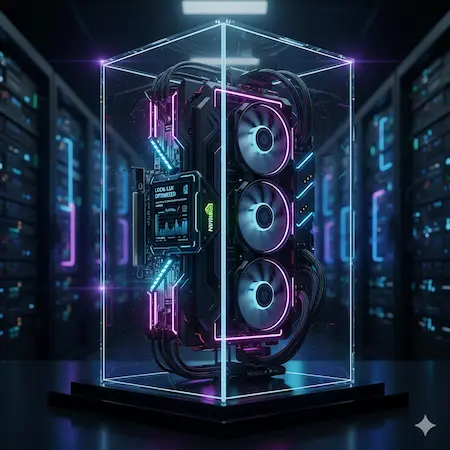

Local LLM VRAM 需求計算機

架設私人 AI 伺服器時,硬體規格是最大門檻。本工具專為 Local LLM VRAM 計算而設計,在買顯示卡前,精準計算 Llama 3 70B 或 Mistral 等模型所需的記憶體大小,確保系統穩定運行。

🧠 Local LLM VRAM 計算機

為什麼精準計算 Local LLM VRAM 那麼重要?

在本地端部署大型語言模型時,顯示卡記憶體(VRAM)是關鍵。一旦模型大小超過 VRAM 容量,系統會被迫使用速度極慢的系統記憶體(RAM),導致推論速度從每秒 50 個 Token 暴跌至 1 個 Token 以下。透過精準計算,您可以避免這種「降速」災難,並省下購買過高規格硬體的冤枉錢。

7B、70B 與 VRAM 的關係

模型參數(Parameters)代表 AI 的大腦容量。一般來說,參數越多,模型越聰明,但佔用的 VRAM 也成正比。例如 8B 模型適合入門級顯示卡,而 70B 的高階模型通常需要兩張 RTX 3090 或 4090 才能在不犧牲速度的情況下完整載入。

量化技術 (Quantization) 如何節省記憶體?

【量化】是 Local LLM 重要觀念,原本 FP16(16-bit)的模型非常龐大,但透過 GGUF 格式將其壓縮至 4-bit (Q4_K_M) 甚至 3-bit,可以節省將近 75% 的 VRAM 空間,且智慧程度僅有微幅下降。本計算機已內建常見的量化數據,可快速評估可行性。

常見問題

跑 Llama 3 8B 需要多少 VRAM?

使用最常見的 Q4_K_M 量化版本,Llama 3 8B 大約需要 6GB 到 8GB 的 VRAM。NVIDIA RTX 3060 12GB 或 RTX 4060 或 RTX 5070 都可以順暢運行。

為什麼我的 12GB 顯卡跑不動 8GB 的模型?

除了模型本身(Weights)佔用空間外,作業系統(Windows)、螢幕顯示以及推論時產生的 KV Cache 都會佔用 VRAM。建議預留 10-20% 的緩衝空間,不要算得剛剛好。

Q4 和 Q8 量化差別很大嗎?

在回答品質上,Q4 與 Q8 的差異通常人眼難以察覺,但在 VRAM 佔用上,Q8 會比 Q4 多出一倍。對於大多數本地端使用者,Q4_K_M 是效能與品質的最佳平衡點。

什麼是 KV Cache?

KV Cache 是模型在生成文字時,為了不重複計算之前看過的內容而暫存的資料。當您設定的 Context Window(上下文)越長,KV Cache 佔用的 VRAM 就會越多。

系統記憶體 (RAM) 很重要嗎?

當 VRAM 足夠時,RAM 重要性較低。但如果您打算使用 CPU 運算(因為顯卡跑不動),或是模型載入過程中,系統 RAM 必須要大於模型檔案大小,否則會發生載入失敗。

什麼是 GGUF?

70B 模型真的比 8B 強很多嗎?

是的。70B 模型在邏輯推理、寫程式碼、以及遵循複雜指令的能力上,遠超 8B 模型。如果您的硬體允許,70B 能提供接近 GPT-4 等級的體驗。

如果 VRAM 不夠會發生什麼事?

輕則程式崩潰(OOM Error),重則系統會調用共用 GPU 記憶體(使用系統 RAM),導致生成速度變得極度緩慢,可能從每秒 30 個字變成每 5 秒 1 個字。