這篇教你如何使用 Python + LLaMA 大型語言模型,免費自架免費版 AI 會議紀錄系統。只要提供會議錄音檔或影片檔,就能自動整理成中英文摘要,無需依賴網路,不怕資料外洩!

為什麼選擇自架AI 會議紀錄系統呢?

資訊安全:敏感資料不經過第三方伺服器

低成本:不需要每月付費訂閱

高客製化:可加入自己專屬提示詞或更改參數

支援繁中市場:中文處理精準度高

準備軟硬體

硬體:

使用兩台 Windows 11 電腦來實作,將整體流程記錄下來,提供給有需要整理會議紀錄的讀者參考。

| 高階伺服器 | 家用電腦 | |

| CPU | AMD EPYC 7542 (32C/64T) | AMD Ryzen 4650G (6C/12T) |

| RAM | 128GB DDR4 3200 | 32GB DDR4 3200 |

| GPU | 無 | 無 |

| Llama 模型 | Llama-3.3-70B-Instruct.Q8_0 | Llama-2-7B-Chat-GGUF |

延伸閱讀:本地部署 AI 會議紀錄工具實作教學:Windows 11 + GPU加速

軟體:

Python 3.13.5:官方下載連結

Spyder IDE:官方下載連結

Visual Studio Build Tools:官方下載連結

Git:官方下載連結

GGUF 模型:MaziyarPanahi/Llama–3.3-70B-Instruct-GGUF

GGUF 模型:TheBloke/Llama-2-7B-Chat-GGUF

Visual Studio 安裝時要選哪個選項?

要選【 C++ 桌面開發】這個選項,在右手邊視窗中可以看到包含:

MSVC v143(C++ 編譯器)

Windows 11 SDK

CMake(可另外安裝新版)

C++ CMake 工具 for Windows

安裝 Python 3.13.5 或更新版本注意事項

第一次安裝 Python 時,務必勾選【將 Python 加入環境變數】這個方塊。

安裝 Spyder 與 Git 注意事項

基本上這兩個軟體沒有特別要設定的地方,使用預設選項一直按下一步完成安裝即可。

AI 會議紀錄專案架構

專案路徑與專案名稱( E:\28_Python\09_llama_CPU_Meeting_Minutes\ )會根據你的狀況而有不同,不過專案底下的資料夾結構如下所示:

E:\28_Python\09_llama_CPU_Meeting_Minutes\

├── llama.cpp\ ← CPU 版 llama.cpp 原始碼(已編譯)

├── config.py ← 參數設定檔(含硬體優化)

├── main.py ← 主程式

├── models\ ← 存放 GGUF 模型

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00001-of-00006.gguf

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00002-of-00006.gguf

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00003-of-00006.gguf

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00004-of-00006.gguf

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00005-of-00006.gguf

│ └── Llama-3.3-70B-Instruct.Q8_0.gguf-00006-of-00006.gguf

├── input\ ← 字幕輸出檔案 (Whisper 逐字稿)

│ └── xxx_Caption.txt

├── output\ ← 會議紀錄產出

│ ├── xxx_Meeting_Minutes_zh.md

│ └── xxx_Meeting_Minutes_en.md

└── venv\ ← Python 虛擬環境(含 llama.dll)下載的 Llama 模型檔,要放在【 E:\28_Python\09_llama_CPU_Meeting_Minutes\ 】

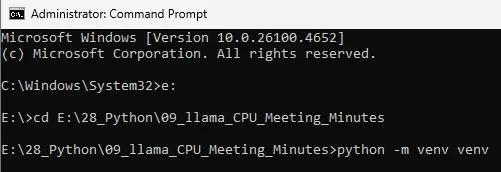

建立 Python 虛擬環境

在 Windows 搜尋列輸入【cmd】,用【以系統管理員身分執行】命令提示字元程式。

cd E:\28_Python\09_llama_CPU_Meeting_Minutes

python -m venv venv

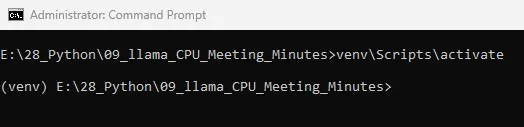

venv\Scripts\activate切換到專案路徑後,使用上述指令即可建立 Python 虛擬環境。範例如下:

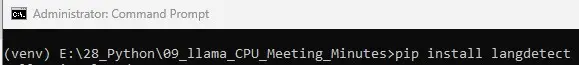

在視窗最左邊看到(venv),代表已經進入 Python 虛擬環境。

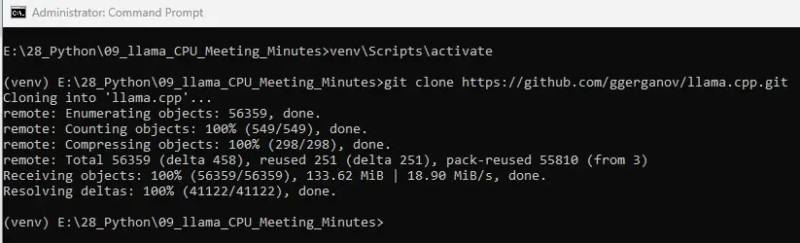

在虛擬環境下安裝必要套件

git clone https://github.com/ggerganov/llama.cpp.git

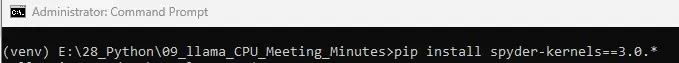

pip install spyder-kernels==3.0.*

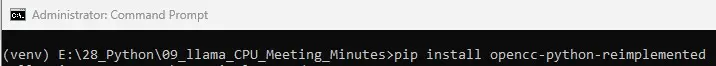

pip install opencc-python-reimplemented

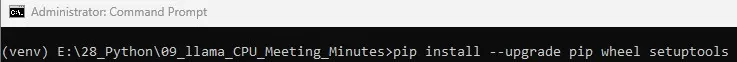

pip install --upgrade pip wheel setuptools

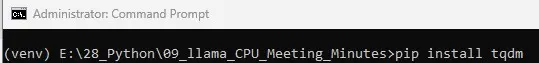

pip install tqdm

pip install langdetect

pip install llama-cpp-python --upgrade步驟 1:

在虛擬環境下安裝 llama.cpp 主程式。

git clone https://github.com/ggerganov/llama.cpp.git

步驟 2:

pip install spyder-kernels==3.0.*

步驟 3:

pip install opencc-python-reimplemented

步驟 4:

pip install –upgrade pip wheel setuptools

步驟 5:

pip install tqdm

步驟 6:

pip install langdetect

步驟 7:

pip install llama-cpp-python –upgrade

會安裝最新版 llama-cpp-python 到 Python 虛擬環境下。利用下面指令確認是否安裝成功及安裝版本:

pip show llama-cpp-python

自行編譯 llama.cpp

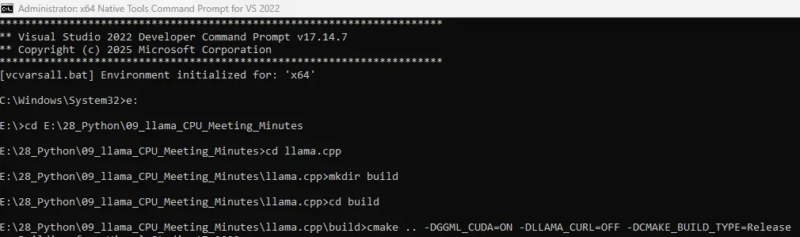

在 Windows 搜尋列輸入【x64 Native Tools Command Prompt for VS 2022】,用【以系統管理員身分執行】編譯程式。

步驟 1:

切換到專案資料夾的路徑下

e:

cd E:\28_Python\09_llama_CPU_Meeting_Minutes步驟 2:

進入【llama.cpp】後,建立【build】資料夾,然後進入【build】資料夾。

cd llama.cpp

mkdir build

cd build步驟 3:

使用 CMake 編譯 llama.cpp,參數說明如下:

-DGGML_OPENBLAS=ON:開啟使用 OpenBLAS 函式庫,用於提升 CPU 下執行時的速度,特別是多執行緒、矩陣乘法。

-DLLAMA_CURL=OFF:不使用 curl 相關功能,不啟用 llama-server 的下載功能,只要離線推論,不需要內建 HTTP 請求。

-DCMAKE_BUILD_TYPE=Release:指定建置模式為 Release,關閉除錯資訊,編譯最終可執行檔時都該用 Release。

cmake .. -DGGML_OPENBLAS=ON -DLLAMA_CURL=OFF -DCMAKE_BUILD_TYPE=Release

步驟 4:

開始執行【編譯動作】,參數說明如下:

–build .:開始編譯專案

–config Release:指定用 Release 模式來編譯,效能最佳化

cmake --build . --config Releasellama.cpp 編譯後檔案要複製到哪裡?

整個編譯 llama.cpp 大約會耗時 30 分種左右,完成後將【E:\28_Python\09_llama_CPU_Meeting_Minutes\llama.cpp\build\bin\Release\】路徑下生成的 4 個 dll 檔案:

E:\28_Python\09_llama_CPU_Meeting_Minutes\llama.cpp\build\bin\Release\

├── xxx.xx

├── llama.dll

├── ggml-cuda.dll

├── ggml.dll

└── ggml-openblas.dll複製到 venv 環境下的 Scripts 資料夾【E:\28_Python\09_llama_CPU_Meeting_Minutes\venv\Scripts\】。

E:\28_Python\09_llama_CPU_Meeting_Minutes\venv\Scripts\

├── llama.dll

├── ggml-cuda.dll

├── ggml.dll

├── ggml-openblas.dll

└── 其他檔案編譯後 llama.dll 檔案也要放在【E:\28_Python\09_llama_CPU_Meeting_Minutes\venv\Lib\site-packages\llama_cpp\】。

E:\28_Python\09_llama_CPU_Meeting_Minutes\venv\Lib\site-packages\llama_cpp\

├── llama.dll

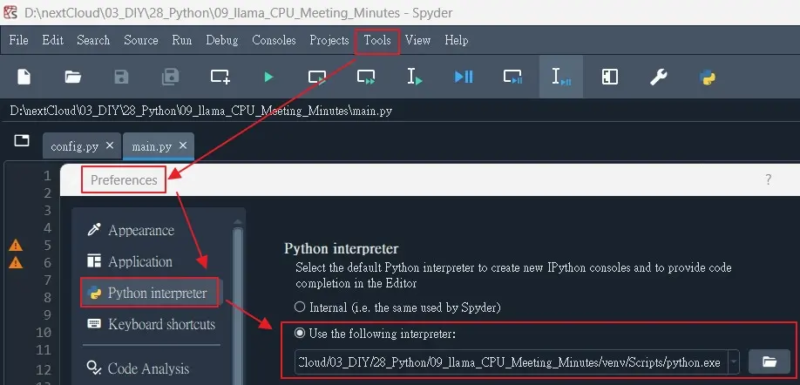

└── 其他檔案 執行程式時,要指定 Python 虛擬環境下的【Python.exe】,然後重開機。

建立 OpenAI Whisper 逐字稿程式

假使你有生成逐字稿的方法,可以略過這一章節。

步驟 1:

建立另一個專案【06_Whisper】,目的是將會議錄音檔或影片檔生成逐字稿。專案架構如下:

E:\28_Python\E:\28_Python\06_Whisper\

├── main.py ← ✅ 一鍵執行主程式(OpenAI Whisper)

├── models\ ← 存放large-v3.pt模型

│ ├── large-v3.pt

├── input\ ← ✅ 音訊檔或影片檔

│ └── xxx.mp4

│ └── xxx.m4a

│ └── xxx.wav

│ └── xxx.mp3

├── output\ ← ✅ 字幕輸出檔案 (Whisper 逐字稿)

│ └── xxx_subtitle.txt

└── venv\ ← Python 虛擬環境(含 llama.dll)步驟 2:

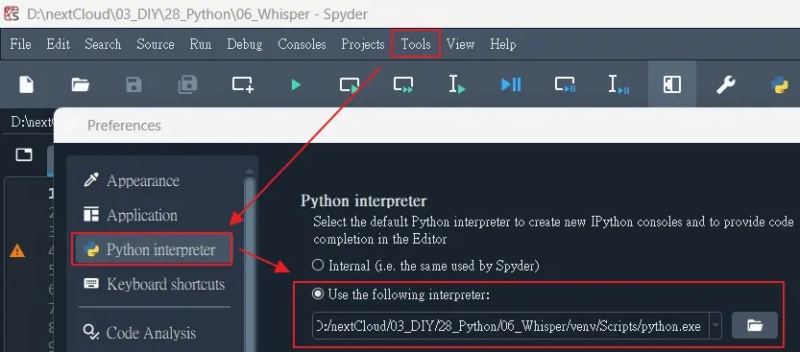

建立 Python 虛擬環境,過程同上一個章節。

cd E:\28_Python\06_Whisper

python -m venv venv

venv\Scripts\activate步驟 3:

安裝 OpenAI Whisper 逐字稿程式與套件

# 安裝 Whisper(官方版本)

pip install git+https://github.com/openai/whisper.git

python.exe -m pip install --upgrade pip

# 升級 pip、wheel、setuptools(確保安裝不出錯)

pip install --upgrade pip wheel setuptools

# 安裝 Spyder 需要的 kernels(如果你是用 Spyder)

pip install spyder-kernels==3.0.*

# 繁體中文轉換(如果需要轉簡繁)

pip install opencc-python-reimplemented

# 安裝 PyTorch(CUDA 12.8 對應 GPU 版)

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128

# 如果是 CPU-only 請改用:

# pip install torch torchvision torchaudio

# 安裝 tqdm 進度條

pip install tqdm

# 安裝語言偵測

pip install langdetectOpenAI Whisper 模型會自動下載到電腦中,假使想要在其他電腦也可以執行逐字稿程式,而不想重複下載模型的話,可以到以下路徑複製模型到專案中【models】。Whisper 模型會存放在電腦快取資料夾:C:\Users\<你的帳號>\.cache\whisper\large-v3。

執行程式時,要指定 Python 虛擬環境下的【Python.exe】,然後重開機。

常見問題

Q1:AI 會議紀錄神器應用場景有哪些?

A1:

1、ZOOM / Teams / Google Meet 視訊會議紀錄

2、客戶訪談逐字稿整理

3、培訓講座重點摘要

4、國內外跨國會議(中英文雙語皆可)

Q2:會議紀錄摘只要支援繁中嗎?

A2:搭配 OpenAI Whisper,就可以支援中文、英文、混合語言輸出。

Q3:會議錄音檔或影片檔上傳到雲端嗎?

A3:不用上傳到雲端或第三方伺服器!只要把檔案放在自己架設的電腦硬碟就可以生成條列式摘要了。

Q4:AI 會議紀錄神器運作時,需要連上網路嗎?

A4:軟體安裝完成後,電腦即使在沒有網路連線的情況下,也可以執行程式生成會議記錄摘要。

Q5:零基礎也能上手嗎?

是的!按照本篇文章的步驟,也能正確執行程式離線生成會議重點紀錄。

上班族自架 AI 會議紀錄神器很難嗎?

按照本篇文章,按圖施工,上班族也能自架 AI 會議紀錄系統。

資訊安全:敏感資料不經過第三方伺服器

低成本:不需要每月付費訂閱

高客製化:可加入自己專屬提示詞或更改參數

支援繁中市場:中文處理精準度高

生成的條列式摘要不如預期的話,可以試著修改 09_llama_CPU_Meeting_Minutes.zip 的 config.py 中【ZH_PROMPT】與【EN_PROMPT】提示詞內容。