什麼是本地部署 LLM ( Large Language Model, 大型語言模型 )?就是將 AI 模型安裝在自己的電腦上來執行,而不是透過網路連線到雲端服務伺服器來執行程式得到結果。優點是:完全離線也可以運行大型語言模型,生成文字、中英文會議摘要、翻譯、對話等任務。

前一篇文章( AI 會議紀錄神器,上班族自架 Windows 11 + LLaMA 生成中英文摘要實作 )是使用純 CPU 的方式,透過 OpenAI Whisper 模型將語音或影片生成逐字稿後,再利用本地部署 LLM 的方式將逐字稿生成中英文會議摘要。這篇文章分享如何本地部署使用 GPU 來加速生成 AI 會議記錄逐字稿,可大幅縮短時間。

本地部署 Llama 硬體需求

Llama 是 Meta 推出的通用大型語言模型,優勢在於硬體需求較低,可安裝在個人電腦運行,提供類似 OpenAI ChatGPT 的服務。

輕量用途

建議使用參數量 7B (70 億) 以下的模型。

| 硬體 | 規格 |

|---|---|

| CPU | Intel i5 / Ryzen 5 (多核心佳) |

| RAM | 32 GB 以上 |

| GPU | 可有可無 |

| SSD | 閒置容量 > 30 GB |

| OS | Windows 11 / Linux |

GPU 加速

根據 GPU VRAM 的大小,使用適合參數量的模型:

8B:VRAM > 12 GB

70B:VRAM > 70 GB 或使用分層 CPU + GPU ( > 12 GB VRAM) 混合運行方式

| 硬體 | 規格 |

|---|---|

| CPU | Intel i5 / Ryzen 5 (多核心佳) |

| RAM | 64 GB 以上 |

| GPU | RTX 3060 (12GB 以上),支援 CUDA |

| SSD | 閒置容量 > 100 GB |

| OS | Windows 11 / Linux |

本地部署使用 GPU 加速的 Llama 模型下載

Hugging Face 是知名且安全的模型存放平台,在這裡可以找到很多模型來運行在自己的電腦上。

MaziyarPanahi / Llama-3.3-70B-Instruct-GGUF

unsloth / Llama-3.3-70B-Instruct-GGUF

bartowski / Llama-3.3-70B-Instruct-GGUF

本篇文章範例使用 70B 參數量的模型,採取分層 CPU + GPU 混合運行方式,實現本地部署 AI 會議紀錄工具的實作流程分享。

| 伺服器規格 | |

|---|---|

| CPU | AMD EPYC 7542 (32C/64T) |

| RAM | 128GB DDR4 3200 |

| GPU | Nvidia Tesla T4 (16GB) |

| Llama 模型 | Llama-3.3-70B-Instruct-GGUF |

本地部署 Windows 11 + GPU 加速的安裝步驟

在 Windows 11 上安裝支援 GPU 的 llama-cpp-python ( cuBLAS / CUDA 版本 ) 的完整教學流程。本地部署專案路徑:D:\28_Python\10_llama_GPU_Meeting_Minutes\,專案架構如下:

D:\28_Python\10_llama_GPU_Meeting_Minutes\

├── llama.cpp\ ← GPU 版 llama.cpp 原始碼(需編譯)

├── config.py ← 參數設定檔(硬體參數、路徑、初始化層數)

├── main.py ← 主程式(生成會議摘要與讀檔程式)

├── utils.py ← 輔助模組(繪圖與統計函式)

├── models\ ← 存放 Llama 模型檔

│ ├── Llama-3.3-70B-Instruct.Q8_0.gguf-00001-of-00006.gguf

│ └── ...(共 6 個檔案)

├── input\ ← ✅ OpenAI Whisper 輸出的逐字稿字幕

│ └── xxx_Caption.txt

├── output\ ← ✅ 中英文會議摘要

│ ├── xxx_Meeting_Minutes_zh.md

│ └── xxx_Meeting_Minutes_en.md

├── log\ ← 所有日誌輸出資料夾

│ └── MODEL_FILE\ ← 模型名稱資料夾(如 Llama-3.3-70B-Instruct)

│ ├── xxx.log ← 純文字 log 檔

│ ├── xxx.csv ← 效能統計 ➡ 可用 pandas 繪圖

│ ├── xxx.jsonl ← JSONL 統計紀錄,方便後續統計與視覺化

│ └── xxx.png ← 視覺化圖片

└── venv\ ← Python 虛擬環境步驟 1:

安裝下面所有軟體:

Python 3.13.5:官方下載連結

Spyder IDE:官方下載連結

Visual Studio Build Tools:官方下載連結

Git:官方下載連結

Visual Studio 安裝時要選哪個選項?

要選【 C++ 桌面開發】這個選項,在右手邊視窗中可以看到包含:

MSVC v143(C++ 編譯器)

Windows 11 SDK

CMake(可另外安裝新版)

C++ CMake 工具 for Windows

安裝 Python 3.13.5 或更新版本注意事項

第一次安裝 Python 時,務必勾選【將 Python 加入環境變數】這個方塊。

安裝 Spyder 與 Git 注意事項

基本上這兩個軟體沒有特別要設定的地方,使用預設選項一直按下一步完成安裝即可。

步驟 2:

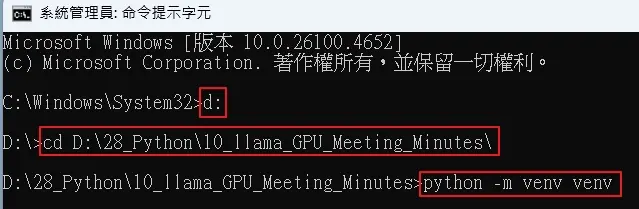

在專案資料夾底下 ( D:\28_Python\10_llama_GPU_Meeting_Minutes\ ),建立 Python 虛擬環境:在 Windows 搜尋列輸入【cmd】,用【以系統管理員身分執行】命令提示字元程式。

cd D:\28_Python\10_llama_GPU_Meeting_Minutes\

python -m venv venv

venv\Scripts\activate

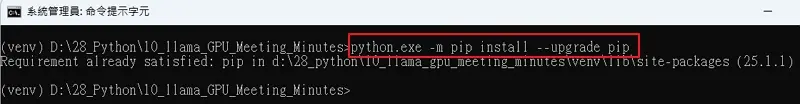

python.exe -m pip install --upgrade pip

執行 venv\Scripts\activate 後,左手邊出現 (venv) D:\28_Python\10_llama_GPU_Meeting_Minutes>,表示安裝成功。接著更新 pip 。

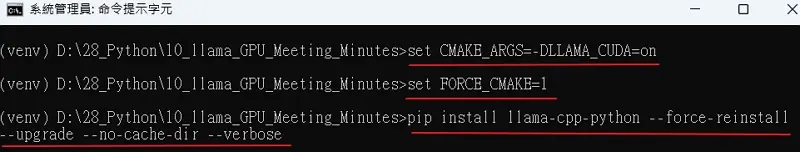

步驟 3:

安裝支援 GPU 的 llama-cpp-python,在 Python 虛擬環境中執行以下三行(在 CMD 視窗),讓 Llama 模型運行時使用 Nvidia GPU 加速。

set CMAKE_ARGS=-DLLAMA_CUDA=on ← 觸發 CUDA kernel 並啟用 CUDA 支援(cuBLAS)的編譯選項

set FORCE_CMAKE=1 ← 強制使用 CMake 重新編譯,而不是 CPU-only 版本

pip install llama-cpp-python --force-reinstall --upgrade --no-cache-dir --verbose

步驟 4:

安裝專案執行的必要套件,其中 pip install torch torchvision torchaudio –index-url https://download.pytorch.org/whl/cu128 是安裝 PyTorch、TorchVision、Torchaudio 三個套件的 GPU ( CUDA 12.8 ) 加速版本。

pip install spyder-kernels==3.0.*

pip install opencc-python-reimplemented

pip install --upgrade pip wheel setuptools

pip install tqdm

pip install langdetect

pip install nvidia-ml-py3

pip install torch torchvision torchaudio --index-url https://download.pytorch.org/whl/cu128

pip install matplotlib pandas seaborn步驟 5:

確認版本與安裝成功。

pip show llama-cpp-python步驟 6:

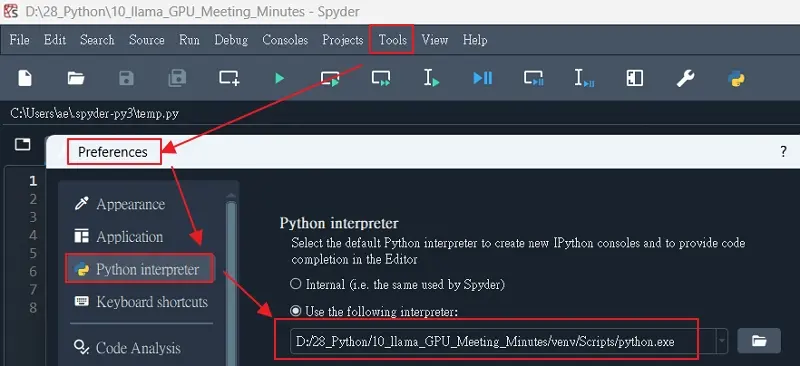

設定 Python interpreter 並指定虛擬環境下的編譯器 D:\28_Python\10_llama_GPU_Meeting_Minutes\venv\Scripts\python.exe,才能執行專案裡的程式。

AI 會議紀錄數據

使用的範例是把 1.5 小時的會議語音逐字稿,利用 llama-cpp-python 生成會議摘要,整個過程記錄在 *.log 當中。

2025-07-25 14:58:37 開始處理 customer_Caption.txt

{“timestamp”: “2025-07-25 14:58:38”, “cpu_name”: “AMD64 Family 23 Model 49 Stepping 0, AuthenticAMD”, “cpu_count”: 64, “total_ram_gb”: 127.87, “gpu_names”: [“Tesla T4”], “model_path”: “models\Llama-3.3-70B-Instruct.Q8_0.gguf-00001-of-00006.gguf”, “n_threads”: 64, “n_ctx”: 8192, “n_gpu_layers”: 8}

2025-07-25 14:58:38 嘗試初始化模型,n_gpu_layers=8,n_batch=128

2025-07-25 15:00:23 初始化成功,n_gpu_layers=8,n_batch=128,耗時 104.59 秒

2025-07-25 15:00:23 成功初始化 LLaMA 模型,使用 GPU 層數:8

[2025-07-25 15:00:23.292800] 開始多輪摘要…

[2025-07-25 15:00:23.292800] [Round 1] 共 2 段開始摘要

[2025-07-25 15:00:23] [Round 1] 段 1,mode=rich,chars=0,tokens=171->4915,ratio=28.743,耗時 3608.47 秒

[2025-07-25 16:00:31] [Round 1] 段 2,mode=rich,chars=28860,tokens=2173->4915,ratio=2.262,耗時 3917.22 秒

[2025-07-25 17:05:49.303548] [Round 1] 總耗時 7526.01 秒

[2025-07-25 17:05:49.303548] [Round 2] 共 26 段開始摘要

[2025-07-25 17:05:49] [Round 2] 段 1,mode=lite,chars=1479,tokens=365->477,ratio=1.307,耗時 343.25 秒

[2025-07-25 17:11:32] [Round 2] 段 2,mode=lite,chars=1485,tokens=362->2457,ratio=6.787,耗時 1748.32 秒

[2025-07-25 17:40:41] [Round 2] 段 3,mode=lite,chars=1496,tokens=400->2457,ratio=6.143,耗時 1753.61 秒

[2025-07-25 18:09:54] [Round 2] 段 4,mode=lite,chars=1480,tokens=397->2457,ratio=6.189,耗時 1750.06 秒

[2025-07-25 18:39:05] [Round 2] 段 5,mode=lite,chars=1492,tokens=395->2457,ratio=6.22,耗時 1750.10 秒

[2025-07-25 19:08:15] [Round 2] 段 6,mode=lite,chars=1469,tokens=395->2457,ratio=6.22,耗時 1750.61 秒

[2025-07-25 19:37:26] [Round 2] 段 7,mode=lite,chars=1470,tokens=388->2457,ratio=6.332,耗時 1749.80 秒

[2025-07-25 20:06:36] [Round 2] 段 8,mode=lite,chars=1485,tokens=396->2457,ratio=6.205,耗時 1750.59 秒

[2025-07-25 20:35:46] [Round 2] 段 9,mode=lite,chars=1495,tokens=397->141,ratio=0.355,耗時 114.18 秒

[2025-07-25 20:37:41] [Round 2] 段 10,mode=lite,chars=1443,tokens=386->443,ratio=1.148,耗時 319.95 秒

[2025-07-25 20:43:01] [Round 2] 段 11,mode=lite,chars=1480,tokens=393->2457,ratio=6.252,耗時 1750.53 秒

[2025-07-25 21:12:12] [Round 2] 段 12,mode=lite,chars=1475,tokens=391->2457,ratio=6.284,耗時 1750.63 秒

[2025-07-25 21:41:22] [Round 2] 段 13,mode=lite,chars=1489,tokens=397->2457,ratio=6.189,耗時 1750.80 秒

[2025-07-25 22:10:33] [Round 2] 段 14,mode=lite,chars=1443,tokens=386->429,ratio=1.111,耗時 310.37 秒

[2025-07-25 22:15:44] [Round 2] 段 15,mode=lite,chars=1499,tokens=392->470,ratio=1.199,耗時 338.75 秒

[2025-07-25 22:21:23] [Round 2] 段 16,mode=lite,chars=1488,tokens=493->2457,ratio=4.984,耗時 1761.70 秒

[2025-07-25 22:50:44] [Round 2] 段 17,mode=lite,chars=1486,tokens=477->2457,ratio=5.151,耗時 1760.42 秒

[2025-07-25 23:20:05] [Round 2] 段 18,mode=lite,chars=1482,tokens=465->2457,ratio=5.284,耗時 1759.21 秒

[2025-07-25 23:49:24] [Round 2] 段 19,mode=lite,chars=1486,tokens=484->2457,ratio=5.076,耗時 1761.03 秒

[2025-07-26 00:18:46] [Round 2] 段 20,mode=lite,chars=1486,tokens=488->2457,ratio=5.035,耗時 1760.96 秒

[2025-07-26 00:48:07] [Round 2] 段 21,mode=lite,chars=1484,tokens=487->2457,ratio=5.045,耗時 1760.92 秒

[2025-07-26 01:17:28] [Round 2] 段 22,mode=lite,chars=1489,tokens=475->2457,ratio=5.173,耗時 1759.92 秒

[2025-07-26 01:46:48] [Round 2] 段 23,mode=lite,chars=1486,tokens=463->2457,ratio=5.307,耗時 1759.38 秒

[2025-07-26 02:16:07] [Round 2] 段 24,mode=lite,chars=1484,tokens=494->2457,ratio=4.974,耗時 1760.90 秒

[2025-07-26 02:45:28] [Round 2] 段 25,mode=lite,chars=1493,tokens=498->2457,ratio=4.934,耗時 1761.52 秒

[2025-07-26 03:14:50] [Round 2] 段 26,mode=lite,chars=91,tokens=39->2457,ratio=63.0,耗時 1714.75 秒

[2025-07-26 03:43:25.488695] [Round 2] 總耗時 38256.19 秒

[2025-07-26 03:43:25.488695] [總耗時] 多輪摘要總耗時: 45782.20 秒

2025-07-26 03:43:26 customer_Caption.txt 處理完成,耗時 45888.23 秒

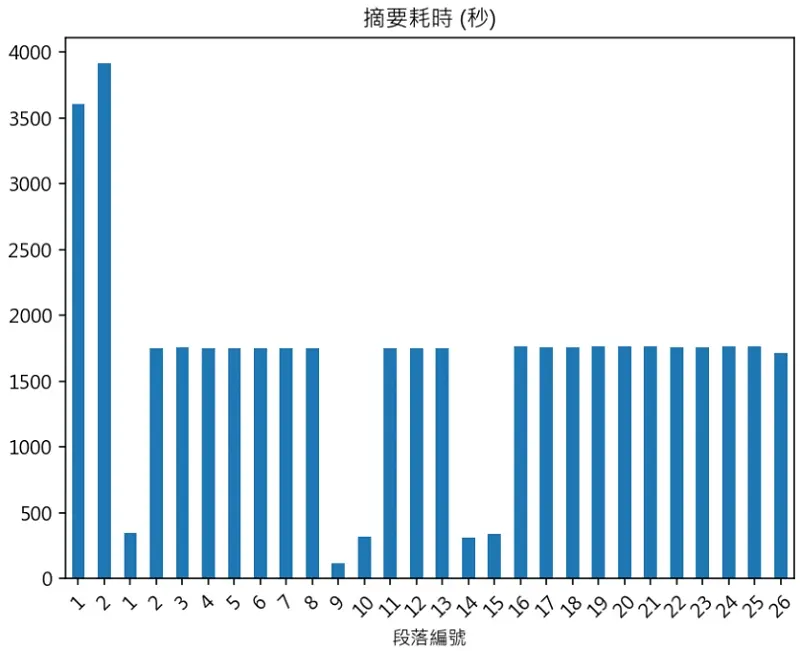

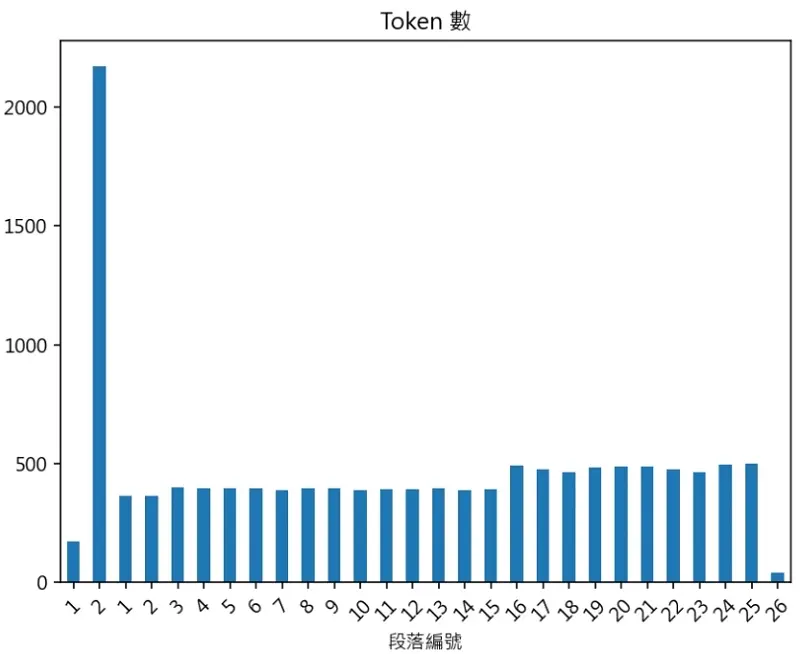

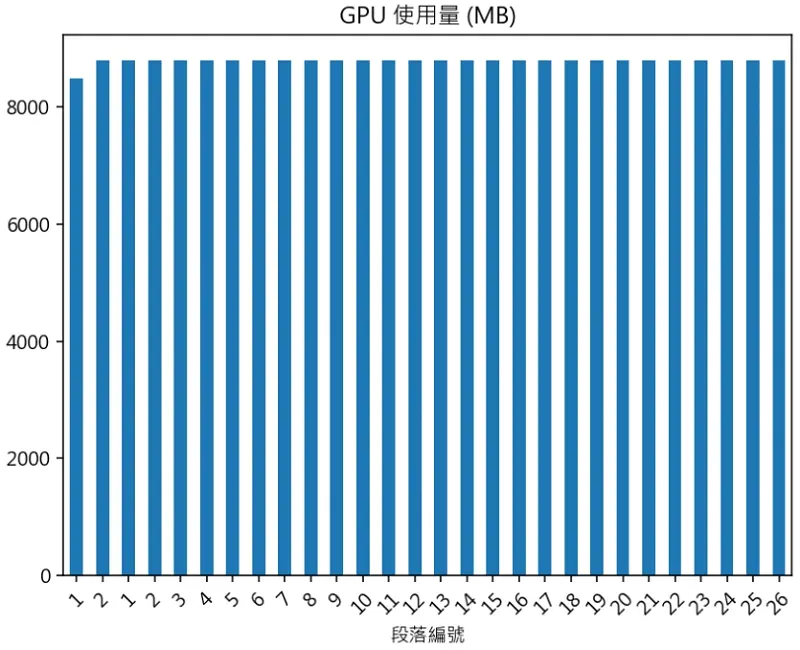

將上述 log 轉換成圖片顯示,會比較好理解。

每段推論耗時

每段推論 Token 數量

GPU VRAM 使用量

本地部署常見問題

Q1:本地部署 LLM ( Large Language Model,大型語言模型 ) 是什麼?

A1:就是在自己的電腦或伺服器上安裝並執行 AI 語言模型,而不是透過雲端服務 ( 如 OpenAI、Google、Anthropic 等 ) 進行推理,且能離線操作、確保資料隱私、控制效能與成本。

Q2:個人電腦跑得動 AI 大型語言模型嗎?

A2:至少要 Intel i5 / Ryzen 5 (多核心佳)以上的 CPU,64GB 甚至是 128GB DDR4 ( DDR5 會更好 ),假使無 GPU,最好挑選小模型 7B 以內;有 GPU 的話,VRAM 越大越適合跑大模型,不過 GPU 的價格也會很貴。

Q3:為什麼要離線跑語言模型呢?

A3:除了保障隱私之外,還可以自由的調整 AI 模型的參數,讓它發揮你想要的功能。

Q4:大型語言模型 LLM 只能選擇 Meta Llama 嗎?

A4:除了 Meta LLaMA 3 8B, LLaMA 3 70B 模型外,還有

1. Mistral AI:Mixtral 8x22B, Mixtral 8x7B

2. Microsoft Phi-3 Mini / Small

3. Google Gemma (2B/7B)

Q5:本地部署工具選擇

A5:

1. llama.cpp / llama-cpp-python 支援 GGUF AI 模型格式。

2. text-generation-webui 支援 HF / GGUF AI 模型格式。

3. vLLM 支援 HF AI 模型格式。

4. transformers ( Hugging Face ) 支援 HF AI 模型格式。

Q6:本地部署如何加快 LLM 匯入速度呢?

A6:程式安裝在主機板 RAID、軟體 RAID、PCIe 4.0 NVMe 或 PCIe 5.0 NVMe,能有效縮短 LLM 匯入時間。

Q7:中英文摘要精準度如何提升?

A7:提示詞( prompt )要精準,把想要的輸出內容具體描述,會很有幫助。

本地部署 AI 會議紀錄工具門檻高嗎?

按照上面的步驟本地部署 AI 會議紀錄工具在電腦上面,其實不難!最大的問題就是:

參數調整:

設定不好會影響穩定性,容易超過 GPU VRAM 的上限,導致程式中斷。

性價比:

想要本地部署 AI 會議紀錄工具,首先要考慮 GPU VRAM 的容量,容量大才跑得動大模型。

提示詞( prompt ):

好的提示詞,能提高會議摘要的精準度;相反的,不適當的提示詞,會讓會議摘要失真。

假使你追求內容品質、摘要邏輯性與條列完整度,能接受數小時後得到會議摘要的話,強烈建議考慮分層 CPU + GPU ( > 12 GB VRAM) 混合運行方式,這對一般上班族而言,能將大型語言模型的功能發揮到極致。

本地部署範例程式碼:Python Example